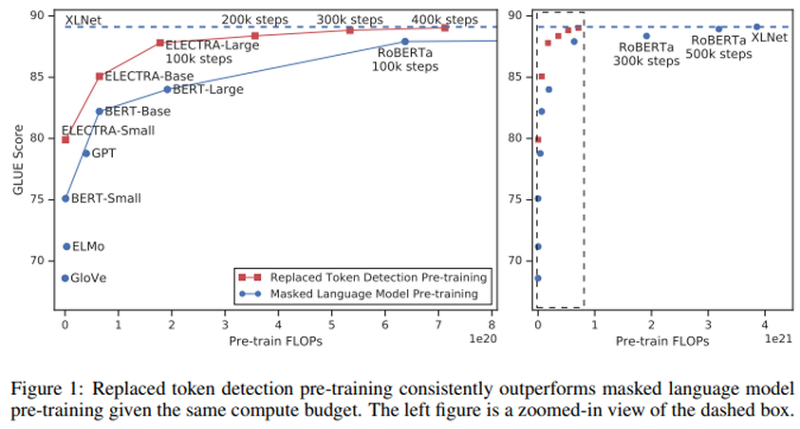

ABSTRACT BERT와 같은 Masked language modeling(MLM) pre-training 방법들은 input을 몇몇 [MASK] 토큰으로 교체함으로써 손상시키고, 모델이 원래 토큰을 만들어내도록 훈련시킨다. 비록 이 방법들이 downstream..

ELECTRA: PRE-TRAINING TEXT ENCODERSAS DISCRIMINATORS RATHER THAN GENERATORS 글에 대한 티스토리 블로그 포스트 내용이 없거나, 요약내용이 적습니다.

아래에 원문링크를 통해 ELECTRA: PRE-TRAINING TEXT ENCODERSAS DISCRIMINATORS RATHER THAN GENERATORS 글에 대한 상세내용을 확인해주시기 바랍니다.

원문링크 : ELECTRA: PRE-TRAINING TEXT ENCODERSAS DISCRIMINATORS RATHER THAN GENERATORS

![[DL Basic] 3강 Optimization [DL Basic] 3강 Optimization](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FlBWkG%2FbtrsMdYCZWX%2F5CFf9a8PEWGCG4ksyUC1M1%2Fimg.png)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티