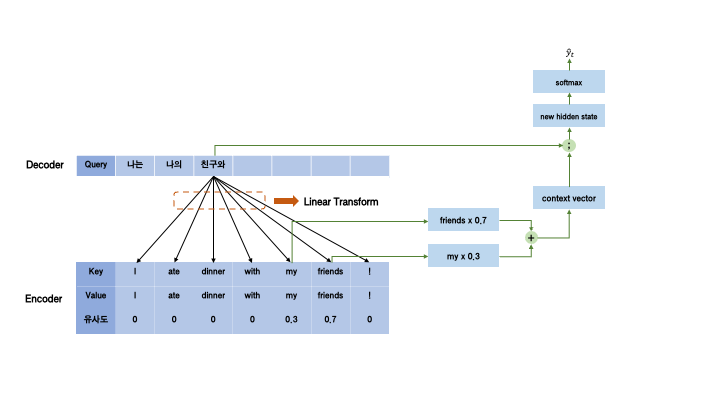

지난 게시글에서 시퀀스-투-시퀀스(Sequence-to-Sequence, seq2seq)를 알아보았다. 시퀀스-투-시퀀스(Sequence-to-Sequence, seq2seq)란? - 기본 구조편 시퀀스-투-시퀀스(Sequence-to-Sequence, seq2seq)는 입력된 시퀀스로부터 다른 도메인의 시퀀스를 출력하는 모델이다. 기계번역, 챗봇, text summarization 등 다양한 분야에서 사용되지만, 모델 자체의 이해 gbdai.tistory.com 그러나, 이러한 RNN 기반의 시퀀스-투-시퀀스(Sequence-to-Sequence, seq2seq)(Sequence-to-Sequence, seq2seq)에는 다음과 같은 문제가 있다. hidden state에 정보를 저장하는데, capac..

원문링크 : Attention이란?-원리부터 masking까지 (General Luong Attention을 기반으로)

![[Go] Go에서의 변수 [Go] Go에서의 변수](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Ft1.daumcdn.net%2Ftistory_admin%2Fstatic%2Fimages%2FopenGraph%2Fopengraph.png)

![[선형대수학] Gauss-Jordan elimination(가우스-요르단 소거법)과 Solution of linear system [선형대수학] Gauss-Jordan elimination(가우스-요르단 소거법)과 Solution of linear system](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FBkNWT%2FbtrSOxeGtZr%2FOf2xsaSAKrmZKRDg9intMK%2Fimg.png)

![[논문 리뷰] RoBERTa: A Robustly Optimized BERT Pretraining Approach - RoBERTa [논문 리뷰] RoBERTa: A Robustly Optimized BERT Pretraining Approach - RoBERTa](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FcrYwRm%2FbtrTDlxxtRi%2FeCyChXbRn4cEbIK4dJ56BK%2Fimg.png)

![[자료구조] 큐(Queue)의 개념과 구현(2) [자료구조] 큐(Queue)의 개념과 구현(2)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FdgUCgJ%2FbtrGS51Pm8V%2F3aXRt2O0RkKlo66XKlCle1%2Fimg.png)

![[선형대수학] Orthogonality(직교성) [선형대수학] Orthogonality(직교성)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FCaQbG%2FbtrTRHFTqpl%2FWjwKvxuLdZt0KT5AZEiUg1%2Fimg.png)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티