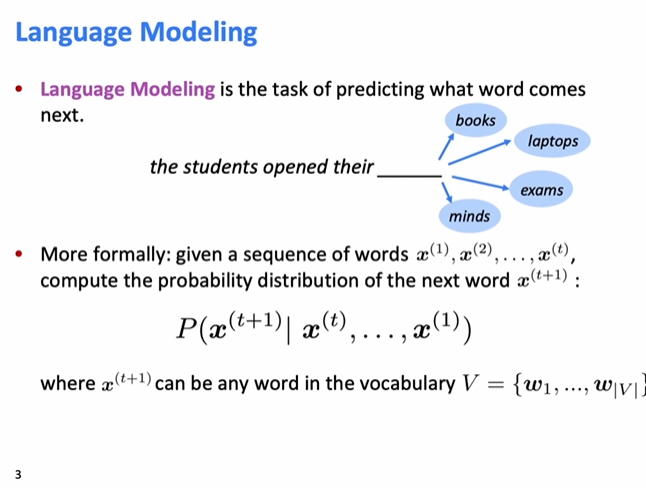

목차 강의내용 language model이란 어떤 단어가 x(t+1)로 올지 예측하는 것. n-gram model n-gram model이란 확률을 추정할때, 전체 단어가 아닌 일부 단어 조합의 출현 빈도만을 계산하는 것. 예제 -> 예측하고자 하는 단어 앞의 세 단어를 제외하고 버린다. -> 하지만 이게 좋은 방식일까? ->확률 추정치를 제대로 구하기는 힘들다 왜냐하면 수 많은 문장을 수집해도 출현 가능한 단어의 조합의 경우의 수는 훨씬 더 클 것이기 때문이다. 단어들의 조합이 조금만 길어져도 코퍼스에서 출현 빈도를 구할 수 없어 분자가 0이 되면서 확률이 0이 되거나, 심지어 분모가 0이 되어 정의 자체가 불가능할 수 있다. ->n을 증가시키는 것이 이러한 희소성 문제를 더 악화시킨다. -> 희소성 문제인데, count가 적어서 발생한다. ->단점은 입력을 처리할 수 있는 신경 구조가 필요하다는 것. ->동일한 가중치W가 적용되지 않는다. ->왼쪽에서 오른쪽으로 가는 것을 tim...

원문링크 : Lecture 6 – Language Models and RNNs

![[C++] Boost 설치 및 환경구성](https://mblogthumb-phinf.pstatic.net/MjAyMzAyMDlfNzEg/MDAxNjc1ODkyNTIyNzUz.fETCGvV0TYfV-4QZuAXx7yCN5WPttiwzqMeLWAnyQJMg.B_FbRwGomOFjNrI1rriqN7rOYjwQIVtJbB1y2sonaaUg.PNG.gkswlcjs2/image.png?type=w2)

![[C++] 백준 11726](https://mblogthumb-phinf.pstatic.net/MjAxOTA4MTVfMjIx/MDAxNTY1ODM5Mjc4ODE2.Z9fepw-_WcDLzNaBBh0deOG7HGTYq_Dwg66OHWjEZc4g.nDmGXKndAgFg9BKLwPySjuXRQdq7qMp-MvgRfaE8Pdsg.PNG.gkswlcjs2/image.png?type=w2)

![[Java] 대응되는 수와 문자](https://mblogthumb-phinf.pstatic.net/MjAyMzA5MjdfMTA0/MDAxNjk1ODA5MDQ0MzY3.uWgirAKmAcCCcVrk38NhT5sUZz4OmU_v691SsDhwQ1Ig.GXvu31k-GjcriNv1py1j6rnvfBlKd57O0L8hI_LjNd8g.PNG.gkswlcjs2/image.png?type=w2)

![[2022 마이 블로그 리포트] 올해 활동 데이터로 알아보는 2022 나의 블로그 리듬](https://mblogthumb-phinf.pstatic.net/MjAyMzAxMDFfODgg/MDAxNjcyNTM5MzYzNTEy.LXCLUY9HoZa00CDatqS505maU9asugZ-Vofgk7F79esg.TkukpOwlkgUicKpV-ZONkkKJ9pPLBHAOVgMJnPwUebog.PNG.gkswlcjs2/my_blog_report.png?type=w2)

![[C++] 프로그래머스 조이스틱](https://mblogthumb-phinf.pstatic.net/MjAyMzAyMThfMzEg/MDAxNjc2NzEyNTY4ODY4.9vJyzNWsacA-erAfK_xhtZ8BD5SAtn9gYjOrr9jsF9Ig.AJMeQQi6EAkR4T7Hp2_mXLmPPZSn99AMk3Dm_hsQ6iQg.PNG.gkswlcjs2/image.png?type=w2)

![[C++] 백준 9372 (인접리스트 풀이)](https://blogimgs.pstatic.net/nblog/mylog/post/og_default_image_160610.png)

![[C++] 백준 14719 (stack/구현)](https://mblogthumb-phinf.pstatic.net/MjAyMjEyMDdfMjcy/MDAxNjcwNDIyMjkzOTAz.j0DbQRGZvxKu_NHqwM0-GBLfaxK93jW3RioA7DI-m-Eg._hKAn10lpvcU4yRbHoirGEAS_y3wlx2f4c43wPjNbZYg.PNG.gkswlcjs2/image.png?type=w2)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티