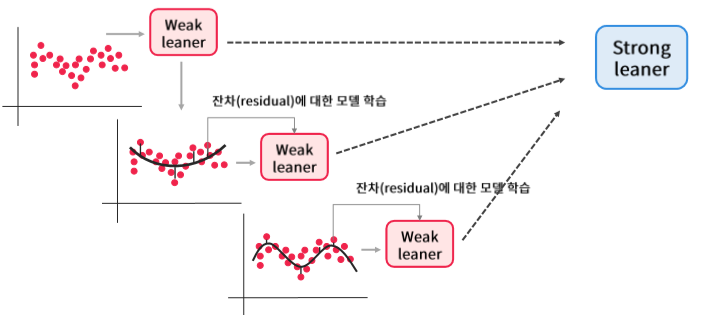

머신러닝 기초 15 - Ensemble Learning - Boosting (부스팅) - Gradient Boosting (그래디언트 부스팅)Gradient Boosting (그래디언트 부스팅) 기본 개념이전 포스팅에서 AdaBoost는 오분류된 데이터들에 더 큰 가중치를 주어 다음 Round 샘플링에 반영한다고 공부하였습니다.Gradient Boosting 은 이전 Round의 모델이 예측한 데이터의 오차를 가지고, 이 오차를 예측하는 weak learner를 만드는 것입니다.아래 식과 같이 x 를 입력받아 y 를 예측하는 모델 ho 가 있습니다.y 는 x 를 학습한 값과 error의 합이 되겠죠.여기서 error는 예측할 수 있는 값과 예측할 수 없는 값으로 나눠집니다.Gradient Boosting은 이 두개의 error 중..........

원문링크 : 머신러닝 기초 15 - Ensemble Learning - Boosting (부스팅) - Gradient Boosting (그래디언트 부스팅)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티