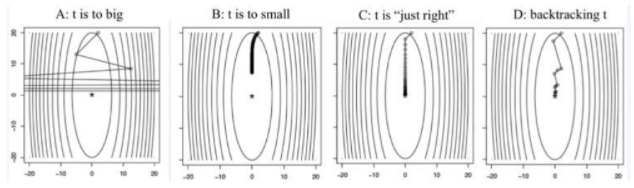

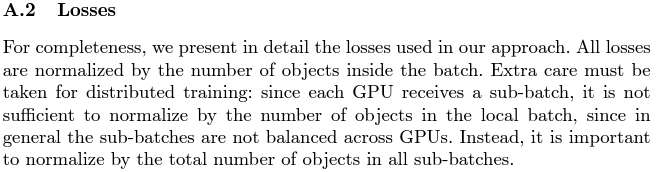

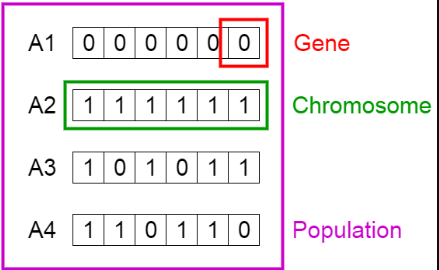

Optimization Optimum sgd Adam optimizer pytorch 나름데로 이런저런 모델을 사용하며, 상황에 맞는 최적화 기법을 사용하다가 점점 늘어나는 양에 점점이해가 되지않아서 한 번에 정리해두려고 합니다. 최적화 기법에 대해 정리하였으며 제가 궁금한 것 위주입니다. 최적화란? 주어진 함수 값에 대해 최대 or 최소화를 진행하는 문제. 우리는 제한적인 함수의 조건을 만족하면서 목적함수를 최대화 시키는 최적의 파라미터를 찾는 것이 목표이다. Convex Optimization 을 가장 많이 사용하게 된다. ( 많은 문제들이 Convex 하기도 하고, Convex하지 않아도 값을 찾는데 많은 도움이 되기 때문이다. 경사하강법 하강하는 방향과 크기, 한 번에 얼마나 움직일지 결정하고 해당 방향으로 이동한다. 특정 문제의 Convex 함수를 구해 기울기를 측정한다. Line search 를 한다. ( Step size인 T를 구하는 과정 ) → 1차원 gradient...

#adagrad

#optimization

#optimizer

#Radam

#regularizaiton

#sgd

#모델최적화

#일반화

#정규화

#최적화

#Optim

#nesterov

#momentum

#adam

#adamp

#adamw

#cliping

#최적화성능비교

#gd

#generalization

#gradientdescent

#loss

#jjunsss

#yolov5

원문링크 : Optimization

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티