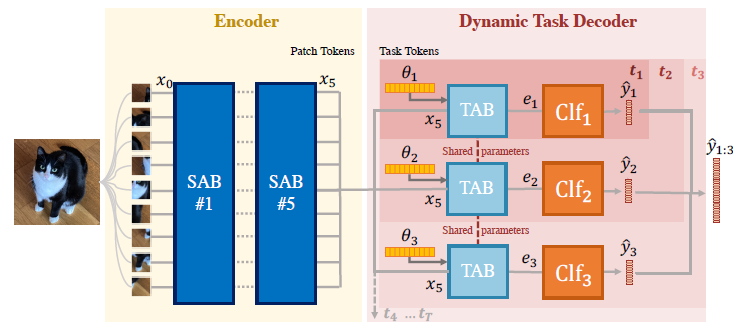

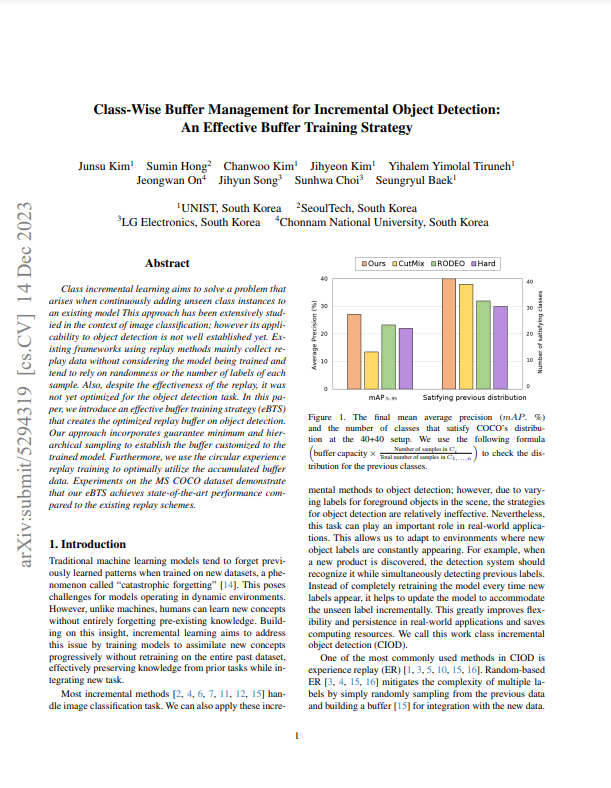

DyTox Transformer Continual Incremental Dynamic Rehearsal CVPR 2022 해당 논문은 Continual Learning을 Transformer에서 다루며, Rehearsal + Dynamic한 방법을 사용하고 있습니다. Method 및 사용법에 대해서만 살펴봅니다. Introduction CL = IL 에서 계속적으로 사용되는 단어인 Catastropic Forgetting을 Transformer를 사용해서 새결하는 방법입니다. 이전의 정보를 잃어버리지 않는 rigidity를 강조하면서도 새로운 데이터에서도 완벽하게 반응하는 Plasticity 를 잘 적용하는 방법은 계속해서 연구되어지는 종목중에 하나입니다. 해당 논문에서는 Dynamic하게 새로운 데이터가 들어옴에 따라 구조를 늘리는 형태로 New Data에 반응하고, 동시에 이전 데이터 중의 일부분을 사용해 Rehearsal Dataset인 Exemplar를 사용해서 Old Dat...

#Catastrophic

#GFLV1

#Head

#Incremental

#IncrementalLearning

#jjunsss

#KD

#LateFusion

#Learning

#Regression

#Rehearsal

#Response

#SAB

#TAB

#forgetting

#FCOS

#CL

#Classification

#CNN

#Confidence

#Continual

#Detection

#Distillation

#Dynamic

#DyTox

#Elastic

#ERD

#ERS

#exemplar

#TaskToken

원문링크 : DyTox: Transformers for Continual Learning with DYnamic TOken eXpansion

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티