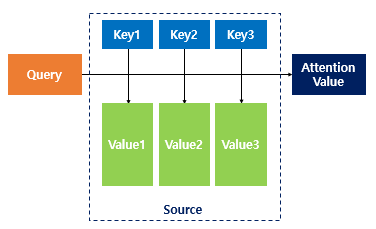

Vision Transformer를 본격적으로 다루기 이전에 한 번 정리를 하기 위해서 작성하는 글입니다. 기본적인 Attention Mechanism에 대해서는 아래의 링크를 참조하였습니다. 1) 어텐션 메커니즘 (Attention Mechanism) 앞서 배운 seq2seq 모델은 **인코더**에서 입력 시퀀스를 컨텍스트 벡터라는 하나의 고정된 크기의 벡터 표현으로 압축하고, **디코더**는 이 컨텍스트 벡터를 통해서 ... wikidocs.net Attention Attention Q : Query, t 시점에 디코더 셀에서의 은닉 K : key, 모든 시점의 인코더 셀의 은닉 상태들 V : Value, 모든 시점의 인코더 셀의 은닉 상태들 위에서 Attention Value란 주어진 Q와 Key의 유사도를 계산하여 각 Value에 연산하여주고, 연산된 Value들을 모두 더해서 리턴하는 값을 의미합니다. 여기서 계산되어지는 Attention Value를 사용해서 각 요소들이 ...

#16x16

#multihead

#multiheadattention

#positional

#pytorch

#residual

#selfattention

#token

#transformer

#VIsion

#visiontransformer

#layernorm

#jjunsss

#attention

#attentionmechanism

#attention동작원리

#bias

#Classificaition

#einsum

#Embeddin

#imagepatch

#Implementations

#inductivebias

#VIT

원문링크 : Vision Transformer ?

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티