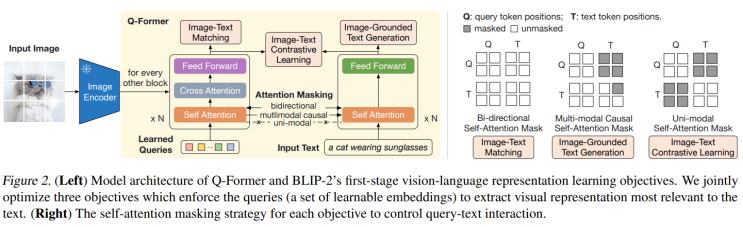

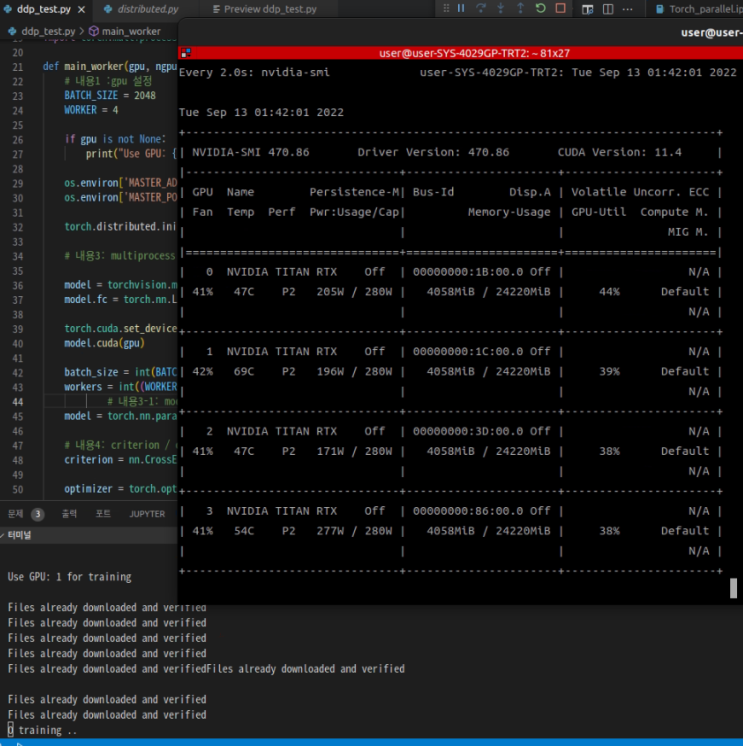

학회: ICML 저자: Junnan Li Dongxu Li Silvio Savarese Steven Hoi 논문: https://arxiv.org/pdf/2301.12597.pdf Summary CLIP과 반대로 이미지를 이해하는 text를 만들어낼 수 있는 방법 기존에 존재하는 pretrained image encoder를 활용해서 이미지 피쳐를 추출하고 고정된 LLMs을 통해서 원하는 결과를 출력하는 방법. 다만 두 개의 feature embedding이 너무 달라서 이를 잘 fitting 해 주는 모델을 추가하였음. Q-Former 라는 모델을 구성하여 image encoder와 LLMs간의 차이를 줄여주도록 수행하였으며 정상적으로 동작하기 위해서 representation training, generating trainig 이라는 두 가지 사전 훈련 과정을 진행 잘 생성하지만 LLMs의 영향을 크게 받기에 간혹 이상한 말을 생성할 수 있으며, 이는 다른 모델로 변경함으로써 해...

#Attention

#imagetocaption

#imagetoprompt

#LLMs

#masking

#OPT

#QFormer

#SA

#SelfAttention

#SharedTransformer

#Transformer

#unimodal

#ImageGrounding

#ICML

#BLIP

#blip2

#Bootstrapping

#caption

#Captioning

#ChatGPT

#CLIP

#Decoder

#Encoder

#FlanT5

#Former

#이미지캡셔닝

원문링크 : BLIP-2: Bootstrapping Language-Image Pre-training with Frozen Image Encoders and LargeLanguageModels

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티