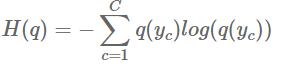

Entropy 불확실성(uncertainty)에 대한 척도. 예측모델의 궁극적인 목표는 불확실성 제어에 있다. 불확실성이 없을 때, 즉 내가 사람이라는 사실에 있어 entropy는 0이다. 어떤 사건이 같은 비율로 발생한다고 하고, 사건의 갯수를 n이라고 하면, entropy는 log(n)이다. 만약 양념치킨과 후라이드 치킨이 반반일 때의 entropy는 log(2) = 0.69이다. 여기서 2는 사건의 갯수로, 양념을 집거나 후라이드를 집는 사건, 총 2개가 된다. 하지만 치킨맛이 2개가 아닌 여러개고, 맛마다 치킨조각이 다르다면, 공식이 필요해진다. H(q) : 엔트로피 C : 범주갯수 = 치킨 맛이 몇개인가 q : 사건의 확률질량함수 (probability mass function) = 각 사건이 ..

원문링크 : Entropy / Cross - Entropy

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티