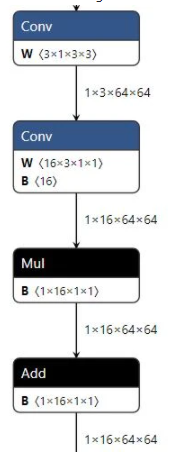

#ShuffleNetv2 #Classification >> 연산량은 inference속도와 절대적인 관계가 없기 때문에, 연산량을 줄이기보다 inference speed에 집중함 >> MAC(memory access cost), degree of parallelism 등 하드웨어마다 연산 성능이 다르기 때문에, 하드웨어에서 지원하는 layer에 맞춰서 구조를 변경해야함 >> shufflenetv2는 FLOPs가 아닌 MAC에 집중하였음. >> pointwise conv 사용할 때, 입출력은 동일한 크기일 때 성능이 좋음 >> group conv는 FLOPs를 감소시키지만, MAC을 증가시켜 조절해서 써야함. >> AutoML로 만든 block들은 gpu에 최적화 되어 있지 않기 때문에 재작업함. >> element-wise operation(add, concat 등)은 gpu에서 큰 비중을 차지하기 때문에, 사용을 줄여야함 (FLOPs는 감소하고, MAC은 증가) >> 이러한 가이드...

#Classification

#ShuffleNetv2

원문링크 : ShuffleNetV2(2018)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티