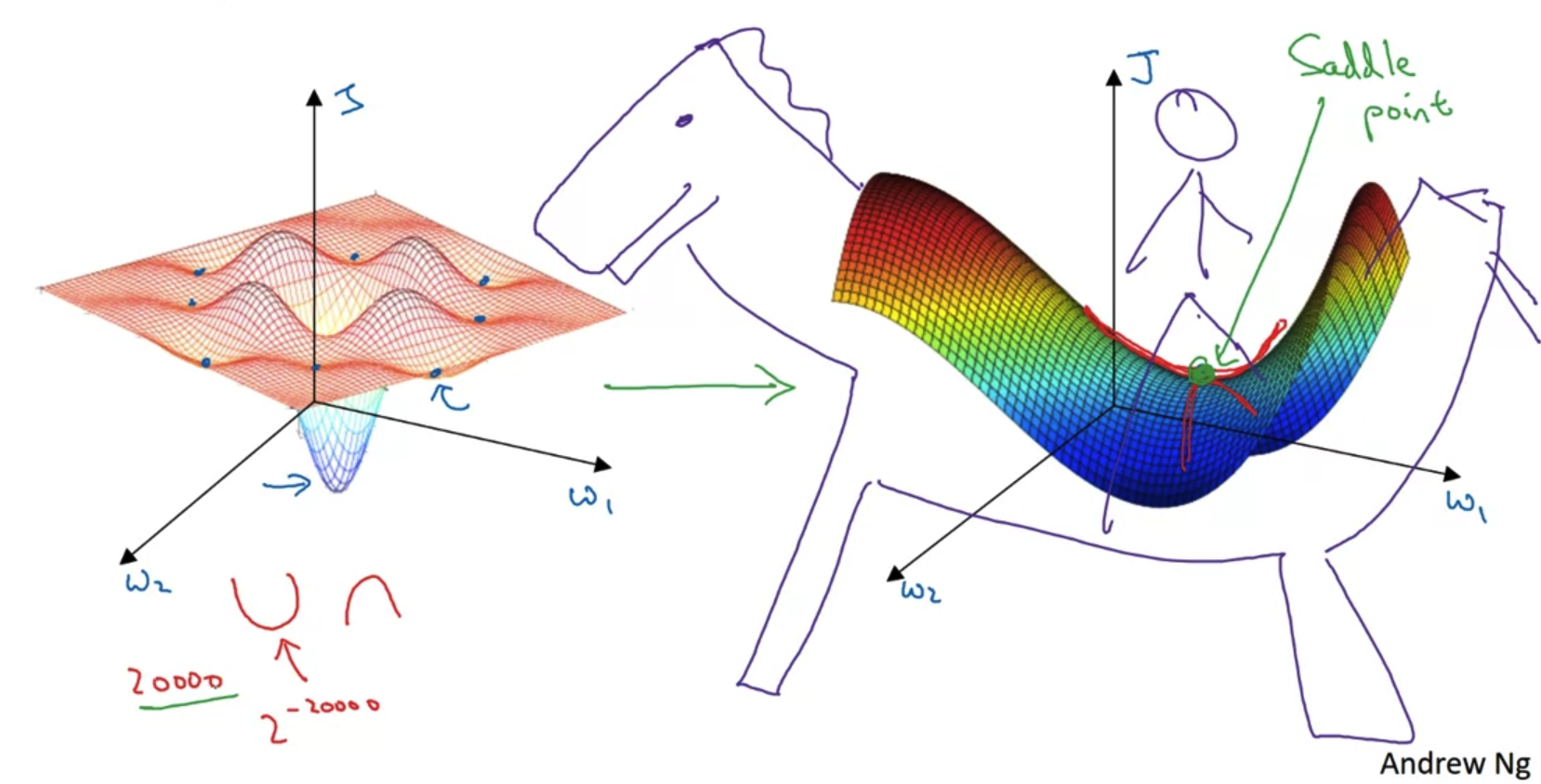

1. Learning Rate Decay Learning Rate Decay 일반적인 mini-batch를 이용하면 파란색과 같은 그래프가 그려진다. 즉, 어느 정도의 noise를 포함한 형태이면서 절대 global minimum에 convergence(수렴)하지 못하고 주변을 배회(wandering)하게 된다. 이를 해결하기 위해 제시된 것이 Learning Rate Decay로 학습이 진행됨에 따라 learning rate을 감소시키는 것을 말한다. 그러면 위 그림에서 초록색과 같은 그래프가 그려진다. 즉, 초반에는 큰 폭으로 학습이 진행되고 이후에는 그 폭을 줄이면서 global minimum에 convergence(수렴)하게 된다. Leraning rate decay epoch는 주어진 데이터를 ..

원문링크 : Optimization Algorithms(4) - Learning Rate Decay

![[프로그래머스] 연속된 부분 수열의 합 (Python) [프로그래머스] 연속된 부분 수열의 합 (Python)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FcTasgz%2FbtshA5wYmSR%2FoUUECq9s6vXawWAofC1qGK%2Fimg.png)

![<Supervision> [OpenAI] Weak-to-Strong Generalization: Eliciting Strong Capabilities With Weak Supervision (2023.12) <Supervision> [OpenAI] Weak-to-Strong Generalization: Eliciting Strong Capabilities With Weak Supervision (2023.12)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FchVeMM%2FbtsDZjswT8s%2FXVRn6YBv2DVMT6nsGiny2K%2Fimg.png)

![[BOJ] 1780 : 종이의 개수 [분할](Python) [BOJ] 1780 : 종이의 개수 [분할](Python)](http://t1.daumcdn.net/tistory_admin/static/images/openGraph/opengraph.png)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티