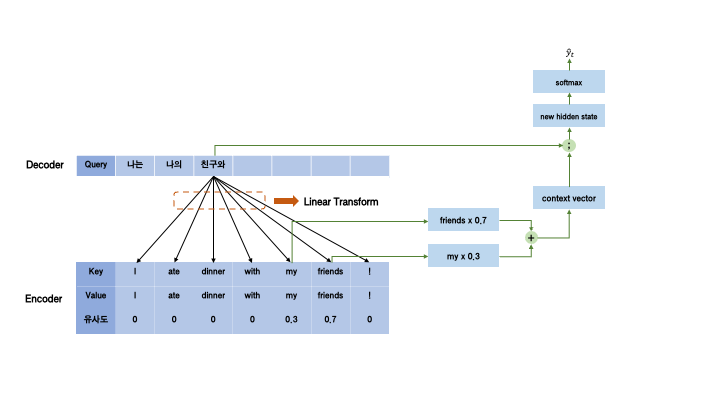

KLD(Kullback-Leibler Divergence) 쿨백-라이블러 발산(Kullback–Leibler divergence, KLD)은 두 확률분포의 차이를 계산하는 데에 사용하는 함수로, 어떤 이상적인 분포에 대해, 그 분포를 근사하는 다른 분포를 사용해 샘플링을 한다면 발생할 수 있는 정보 엔트로피 차이를 계산한다. -Wikipedia- KLD는 두 확률분포 사이의 다름을 측정한다. 주의해야 할 점은, KLD는 두 분포 사이의 거리가 아니라는 것이다. KLD의 수식과, 예시를 보면서 같이 개념을 이해해보자. 두 확률분포 p와 q가 있다고 할 때, p 관점에서 측정한($x$를 sampling 할 때 p에서 sampling) KLD의 수식은 다음과 같다. $$KL(p||q) = -\mathbb{E}..

원문링크 : KL-Divergence와 Entropy, Cross-Entropy란?

![[자료구조] 스택(Stack)개념, 구현 [자료구조] 스택(Stack)개념, 구현](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FDEMTH%2FbtrExY204eb%2Fk7660rZQQRVarFY9oBKKBK%2Fimg.png)

![[자료구조] 큐(Queue)의 개념과 구현(1) [자료구조] 큐(Queue)의 개념과 구현(1)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FbNLIQQ%2FbtrGVkwWXik%2FKDX5uyaqPJFkgs2YN6nJG0%2Fimg.png)

![[JavaScript] 표현식과 문 [JavaScript] 표현식과 문](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Ft1.daumcdn.net%2Ftistory_admin%2Fstatic%2Fimages%2FopenGraph%2Fopengraph.png)

![[자료구조] 해시 테이블(Hash Table)이란? [자료구조] 해시 테이블(Hash Table)이란?](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FdJzqov%2FbtrJ7SLMqsJ%2FfKOcnBBNCKezQ3mwOuZ4Dk%2Fimg.jpg)

![[논문 리뷰] Leveraging Passage Retrieval with Generative Models for Open Domain Question Answering [논문 리뷰] Leveraging Passage Retrieval with Generative Models for Open Domain Question Answering](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FcQho4v%2FbtsdefcWBj9%2FIIBoln9e7FpvX7LbMTmQnK%2Fimg.png)

![[논문 리뷰] Big Bird: Transformers for Longer Sequences [논문 리뷰] Big Bird: Transformers for Longer Sequences](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FbwWPlW%2Fbtr0frXBIeE%2FXMbPRWk5KdaDkarjUtMaTk%2Fimg.png)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티