![[논문 리뷰] Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer [논문 리뷰] Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2Fv20Zn%2Fbtr1bkKLFpz%2Fs9LiZCGVndJM48qnkA3hK1%2Fimg.png)

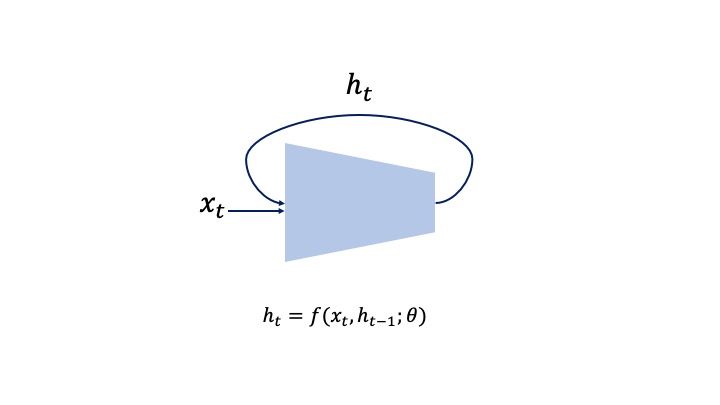

이번 게시물에서는 구글에서 연구하고 발표한 T5를 다룬 논문인 Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer에 대해 다뤄보겠다. 해당 모델의 경우, BART와 같이 Encoder-Decoder 구조를 지니고 있으며, 모든 task에 대해 text-to-text task로 다룬다는 특징을 가지고 있다. 이에 대한 자세한 내용은 아래에서 다루도록 하겠다. 또한, 논문의 양이 매우 긴 편인데(Appendix와 Reference를 제외하고도 40페이지 남짓), 저자들이 T5를 연구하면서 진행한 가설 설정 및 비교 실험을 모두 담아놓았기 때문에 그렇다. 처음부터 차근차근 따라가면 NLP에서의 language mod..

원문링크 : [논문 리뷰] Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer

![[Python] Pypi에 패키지 업로드하기 [Python] Pypi에 패키지 업로드하기](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2F8eeE5%2FbtrWXjuLlEb%2FsBREdBq90BF3ljrQfCzUU0%2Fimg.png)

![[JavaScript] 자바스크립트의 타입 변환 [JavaScript] 자바스크립트의 타입 변환](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Ft1.daumcdn.net%2Ftistory_admin%2Fstatic%2Fimages%2FopenGraph%2Fopengraph.png)

![[자료구조] 연결 리스트(Linked list)와 구현 (2) [자료구조] 연결 리스트(Linked list)와 구현 (2)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2Fd8P5Cp%2FbtrFOwq8deD%2F8Pz9GQQSz3GEo7jk4hGVN1%2Fimg.png)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티