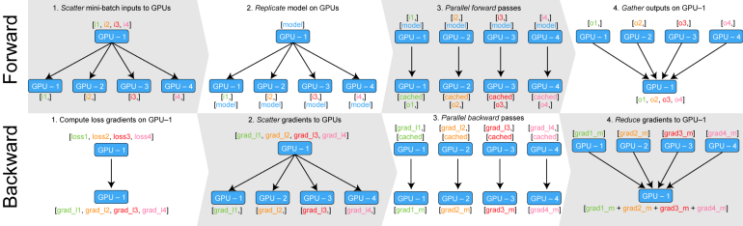

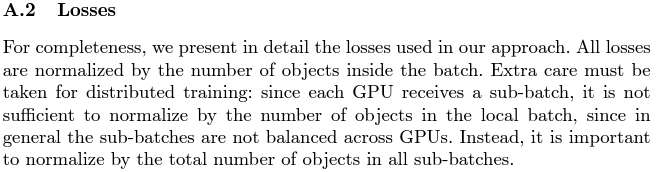

해당 글은 연구실에서 사용하기 위해 조사하였습니다. GPU의 등장으로 빨라진 인공지능 연산을 바탕으로 연산해야하는 모델의 양도 점점 늘어나게 되었습니다. 연산 가능한 파라미터의 수가 늘어날수록 데이터에 대한 피쳐를 많이 뽑아서 다양하게 저장할 수 있기 때문에 끝없이 커지는 모델들이 등장하였는데, 이러한 모델들은 싱글 GPU로는 도저히 감당할 수 없는 연산량을 보였습니다. 모델 하나를 학습하는데 한 달이 걸리기도 하고, 몇 달이 걸리기도 하는데 도저히 이러한 방법으로는 연구를 진행할 수 없었기에 여러 개의 GPU를 사용해 하나의 모델을 학습하는 병렬 GPU의 방법이 급부상하게 됩니다. 그에 맞추어 파이프라인, 라이브러리 등등에서도 GPU를 다루는 방법에 대해 각각 다양하게 제시하였는데 처음 등장했던 DP부터 현재 사용하는 DDP까지 사용법을 알아보고 어떤 코드로 구성되어 있는지, 특정 명령어가 어떠한 동작을 하는지, 어떻게 사용하면 더 극한으로 활용할 수 있을지 등을 정리해보려 작성하...

#AI학습

#torch

#다중지피유

#데이터분산학습

#데이터패러럴

#멀티쓰레드

#멀티지피유

#멀티프로세스

#분산학습

#인공지능GPU

#Pytorch

#MultiGPU

#launch

#Apex

#DataParallel

#DDP

#distributed

#DistributedDataParallel

#DP

#GPU

#GPU여러대사용하기

#jjunsss

#파이토치

원문링크 : Multi-GPU 총정리

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티