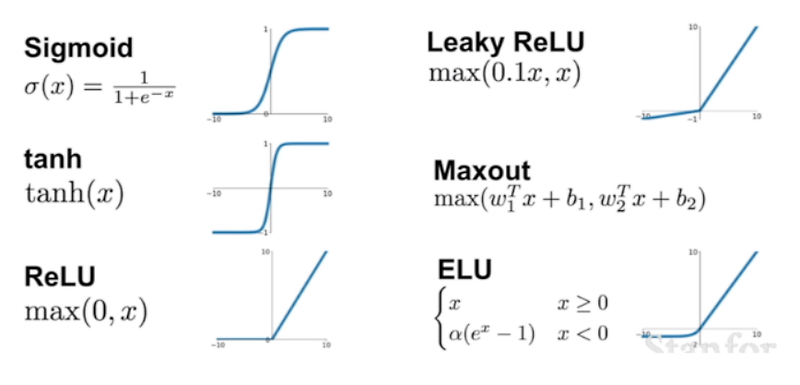

vanishing gradient 현상이 발생한다. (0과 1에 결과값이 포화 saturate 된다. 포화된다는 말 자체가 kill the gradient. 기울기가 죽어버리면 에포크를 많이 돌려도 더이상 학습되지 않는다. ) exp 함수 사용 시 비용이 크다. 요즘은 ReLU를 더 많이 사용한다. Hyperbolic Tangent : 쌍곡선 함수 중 하나. (쌍곡선함수 hyperbolic tuction : 일반 삼각함수와 유사한 성질을 갖는 함수지만 삼각함수와 달리 주기함수는 아니다. tanh 함수는 함수의 중심값을 0으로 옮겨 sigmoid의 최적화 과정이 느려지는 문제를 해결. vanishing gradient 문제 존재. (값이 1, -1에 포화됨) sigmoid, tanh 함수에 비해 학습이 빠..

원문링크 : 활성화함수 종류

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티