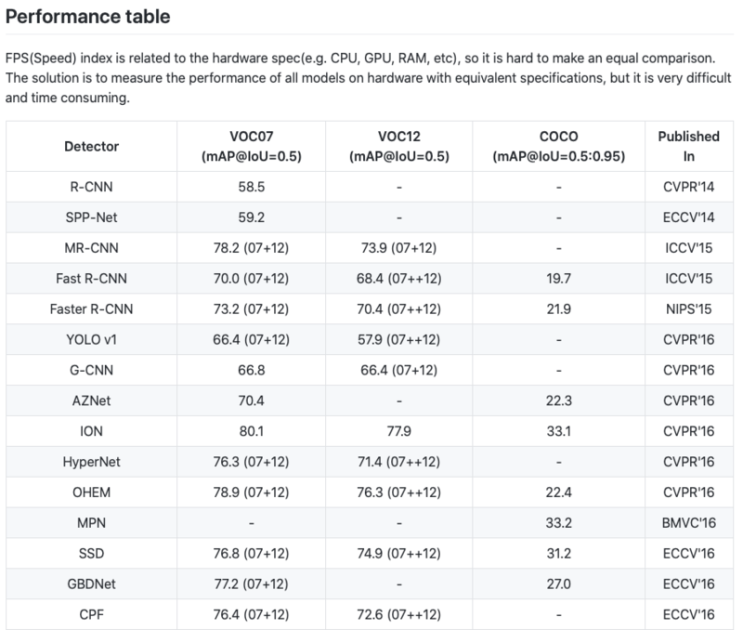

#ResidualAttentionNetwork #Classification >> attention 개념 적용하여 모듈 만듬(inception, residual 조합). 중요한 부분에 가중치 부여. 배경제거하고 더 attention하는 효과있음, soft mask branch와 trunk branch로 구성 >> trunk branch - 입력값으로 특징 추출. 최신 모듈 사용(그림 오른쪽) >> soft mask branch - down sample(pooling), upsample해서 중요한 특징만 살려냄. 특징을 강조하고 배경 제거(그림 왼쪽) >> (1+soft mask branch)*trunk branch로 해서 smb값이 trunck 출력값에 가중치를 줌 안녕하세요! 이번에 소개할 논문은 Residual Attention Network 입니다. Residual Attention Network는 자연어 처리에서 활발하게 이용하고 있는 Attention에서 영감을 받아 탄생한 ...

#Classification

#ResidualAttentionNetwork

원문링크 : Residual Attention Network(2017)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티