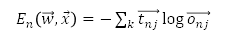

cross Entropy부터 이어서 설명해보겠습니다! cross Entropy는 실제 확률 분포(target)와 예측 확률 분포(output)가 얼마나 유사한가?에 대한 지표로 활용이 됩니다. 유사하게 KL(Kullback Leibler) Divergence 라는 것이 있습니다. KL Divergence= Hp(q)-H(q) Hp(q): 실제 분포와 예측 분포의 cross entropy H(q): 실제 분포의 엔트로피 KL Divergence가 작으면 작을수록 둘이 유사하고, 반대의 경우에는 차이가 큰 경우입니다. NN에서의 error값을 계산하는 이유는 이를 최소화하고자 함에 있습니다. 즉, KL Divergence를 최소화시켜야겠죠. 여기서 cross entropy와 KL Divergence는 결과적으로 동일한 의미를 가집니다. H(q)가 상수이기..........

원문링크 : CNN(Convolution Neural Network) 정리 (4)

![[Unity] 01. 설치하기](https://mblogthumb-phinf.pstatic.net/MjAyMTAyMDFfMjY0/MDAxNjEyMTU3MDIzMTE1.EZWkIjrVhjrK_XHG7ViccsxG68TZoPKlI36_WexsFzcg.RGfPIPaPIjH37tZkUG1_fOkkckh5bgZSDkwK09xvPvYg.PNG.sky__071/%C8%AD%B8%E9_%C4%B8%C3%B3_2021-02-01_142305.png?type=w2)

![[Unity/C#] 스크립트로 자식오브젝트 설정하기](https://blogimgs.pstatic.net/nblog/mylog/post/og_default_image_160610.png)

![[4강] 전달함수(Transfer Functions)](https://mblogthumb-phinf.pstatic.net/MjAyMDEwMTVfMTA4/MDAxNjAyNjk5NjE2MDQw.YUrcZ3Sq5sZut59pjAn7cq5h4FSbLLV03O98hAZZg1gg.z_Zb2OIZpnAbHYqE3Yz_qPwMgVVSHo-Lxb8ndxZDYiQg.JPEG.sky__071/Notes_201015_031443_1.jpg?type=w2)

![[8강] A=LU factorization](https://mblogthumb-phinf.pstatic.net/MjAyMDEwMTNfMjMg/MDAxNjAyNTYwMDI5NjA3.VgIoADfKUAB_ijjXNNeplJpLL4u7CDekoWonyOKax_wg.RmycF6rR_syhgCcosOaF0tZXth15VDDKcmnBl8eIQ3sg.JPEG.sky__071/Notes_201013_122944_1.jpg?type=w2)

![[3강] LTI system](https://mblogthumb-phinf.pstatic.net/MjAyMDEwMTVfMjc5/MDAxNjAyNjk3NDA0ODM2.KKukRcwlPfBpBBMwyiQ7Ej5fk3EHSSslDIpOMvHfAqkg.U51ArJhTg7rUputAlnVNIrX2x-2VujnisDwHypXiiM0g.JPEG.sky__071/Notes_201015_023710_1_%281%29.jpg?type=w2)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티