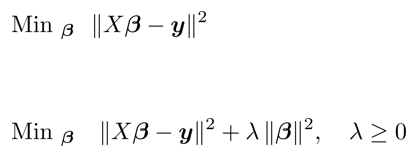

릿지 회귀는 기존의 최소 자승법에 베타 norm을 추가한 것이다. λ값이 있기 때문에 ridge 회귀를 패널 회귀라고 부른다. 릿지 회귀는 어떠한 차별점이 있으며, λ의 의미는 무엇인가? Ridge에서의 intercept ridge 회귀를 사용할 때의 특징은 회귀 계수의 norm이 추가된다는 점이다. 위 식에서는 a,b,c로 작성했고, b,c가 회귀 계수가 된다. 릿지에서 ||β||^2 = β0^2+ β1^2+ β2^2와 같이 쓰는 것이 a^2+b^2+c^2로 쓸 수 있다. 문제는 이 세가지가 얽혀있다는 것이다. 위 세 식은 같은 식이다. 위 식에서 의미하는 바는 β0이 결국 나머지 회귀 계수에 대한 식으로 정리할 수 있다는 것이다. 따라서, β0을 빼고 β1과 β2에 대해서만 norm을 취해도 상관 없어진다. 그 식이 바로 위 식이다. 아예 intercept를 날려버렸고, 이렇게 쓰더라도 큰 문제가 없다. 만일 시그마 부분의 최소값을 찾으려고 하면 최소자승법이 된다. 뒤의 식의 람...

#AI

#패널회귀

#통계학

#통계

#최소자승법

#인공지능

#벌칙회귀

#릿지회귀

#람다

#ridge

#표준화

원문링크 : 패널 회귀 (Panelized Regression), 릿지 회귀 (Ridge Regression)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티