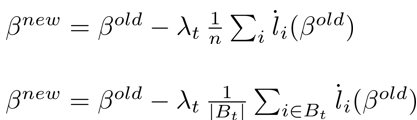

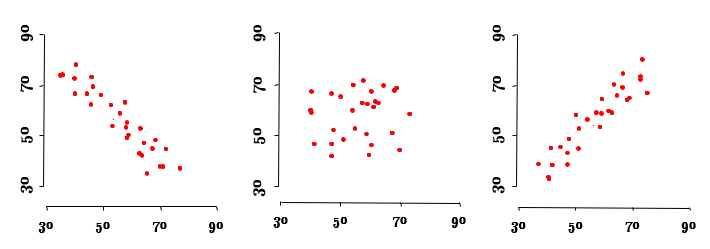

Gradient Formula라고 google검색 시 바로 나오는 사진 Gradient란 기본적으로 미분이다. 위 사진은 Gradient Formula라고 google에 치면 바로 나오는 사진이다. 문제는 L()함수이다. 위 식은 머신러닝에서 회귀계수를 추정하는 방식이다. 문제는 L()함수를 구해서 미분해야 하는데 이 L함수가 매우 복잡하다는 점이다. y=[[xA]B]라는 함수를 보더라도 sigmoid든 softmax든 활성함수를 2번 넣는데 그 중에 선형 변환을 두번이나해야한다. Backpropagation이란 이 복잡한 함수를 이용하여 위에서 부터 아래로 내려가면서 미분하는것이다. Backpropagation이란? Backpropagation은 굳이 번역하면 역전파? 정도로번역되는데 이를 이해하는데에 그리 필수적인 요소는 아니기 때문에 Backpropagtion 단어 자체로 받아들이는 것이 필요하다. 위에서 말했듯, Backpropagation은 L()함수를 위에서부터 아래로 내...

#descent

#Gradient

#Momentum

#SGD

#머신러닝

#인공지능

#통계

#통계학

#회귀계수

원문링크 : Backpropagation과 SGD

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티