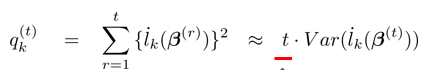

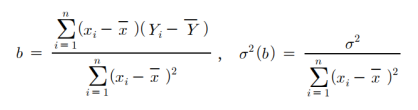

gradient descent방법은 최적해를 찾기 위한 인공지능에서 핵심이 되는 기술이다.gradient는 원래 있던 k번째 베타값을 k+1번째 베타값으로 옮기는 것이 기본이다. 최적화 변수들을 gradient가 음이면 증가, 양이면 감소시키는 방향으로 0으로 이어지게 하는 것이 gradient의 목표이다. 여기서 SGD가 등장해서 계산 목적상 자료를 여러개로 나누어 적용하기 시작했다. 수많은 gradient의 방법들에 대해서 소개하도록 하겠다. SGD SGD는 기본적으로 t에서 t+1로 갈 때 어떻게 하는가에 대한 질문에서 시작한다. 위 방식은 그냥 베타값간에 비교하는 방식이다. SGD는 batch단위로 gradient를 계산한다. k의 의미는 k번째 batch라는 의미이다. 계산 목적상 자료를 여러개로 나누어 gradient를 계산하는 것이 목표이다. 이를 좀 더 간략하게 써보면 다음과 같다. 여기서 η는 가중치를 의미하고 학습률 정도로 생각하면 된다. gradient를 주고 나...

#AdaDelta

#인공지능

#미분

#SGD

#RMSprop

#nesterov

#NAG

#Nadam

#Momentum

#Gradient

#Adam

#Adagrad

#통계학

원문링크 : SGD의 다양한 방식: Momentum, NAG, Adagrad, Adam, RMSprop, AdaDelta, 그리고 Nadam

![[저널 탐색] Hacking Nuclear Stability: Wargaming Technology, Uncertainty, and Escalation](https://mblogthumb-phinf.pstatic.net/MjAyMzEyMjdfMTUz/MDAxNzAzNjQwODczNjE5.S4ojd074_Vm3zel3skzEbP2NwSJwSDhcwsHL1FpRRd8g.ICbYxRiyePubMZ2m0be1JJPkA9aZ87dJDyG8oispNLAg.PNG.tornado720/image.png?type=w2)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티