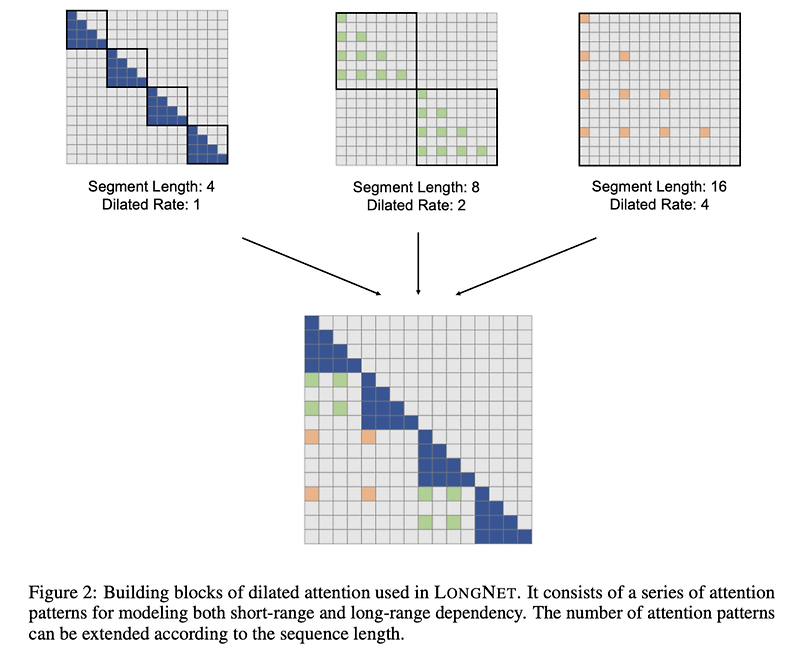

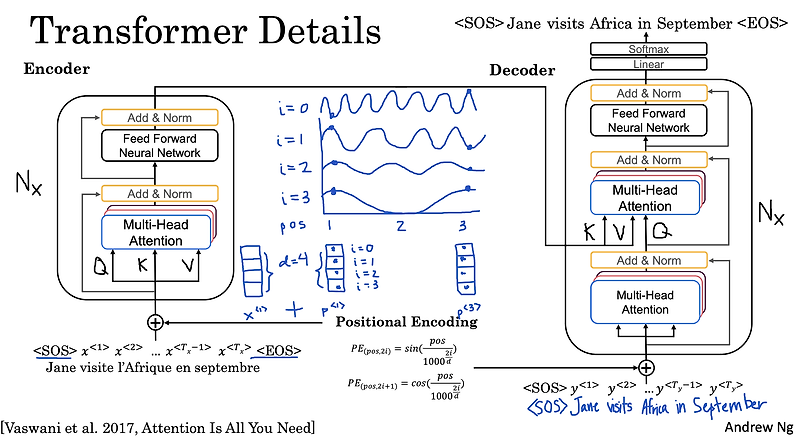

[Microsoft Research] dilated attention을 적용하여 computation complexity를 quadratic → linear 줄임. 엄청나게 긴 입력(1B token)을 처리할 수 있으면서도 성능을 잘 유지할 수 있는 모델 LONGNET을 제시. 배경 transformer 기반의 모델들이 좋은 성능을 보이는 것 이면에는, 엄청나게 많은 자원을 필요로 한다는 문제점이 존재하고 있습니다. self-attention 방식을 생각해보면 하나의 Key가 모든 Query, Value와 연산을 수행하게 되면서 quadratic한 시간 복잡도를 갖게 되기 때문이죠. (쉽게 표현하면 O(N^2)라고 할 수 있겠네요) 결국 모델이 처리할 수 있는 입력의 길이가 상당히 제한되고, 이것이 지금..

원문링크 : <Attention> LongNet: Scaling Transformers to 1,000,000,000 Tokens

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티