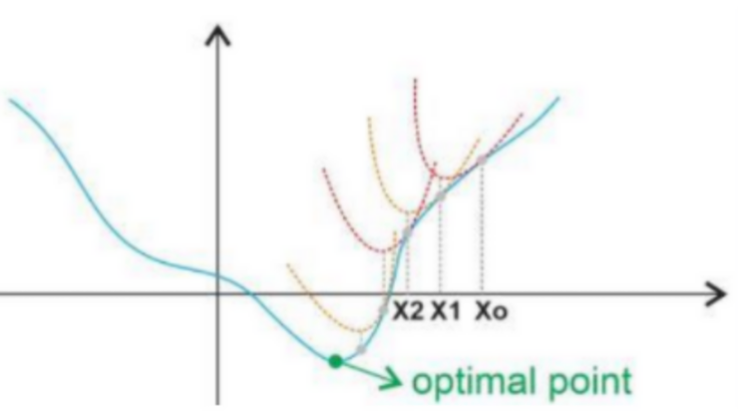

6. Gradient Descent Method 이번에는 가장 기본적으로 물어볼 수 있는 최적화 알고리즘 들에 대해서 알아봅니다. 이번엔 이전에 다룬 내용이 있으므로 같이 첨부 해두겠습니다. Optimization Optimization Optimum sgd Adam optimizer pytorch 나름데로 이런저런 모델을 사용하며, 상황에 맞는 최... blog.naver.com 제가 이전에 리뷰했던 내용입니다. 앵간한 옵티마이저는 대부분 조사해봤기 때문에 훑어보면 도움이 되리라 생각합니다. 이전과 동일하게 간단하게 여기서는 알아보도록 하겠습니다. 뉴턴 스텝(Newton's method) 일반적으로 사용되는 Gradient Descent를 위한 미분 값을 2차 미분에서 얻는 방법입니다. 2차 미분한 그래프의 최소값 방향으로 모델을 최적화하는 것을 말합니다. 해당 방법은 확실하게 수렴할 수 있다는 장점이 있지만, 2차 미분을 해야한다는 점에서과도한 연산량을 필요로 하기에 흔히 사용하...

#AIGS기술면접예시

#유니스트

#유니스트AIGS

#유니스트AI대학원

#유니스트AI대학원질문

#유니스트석박통합면접

#유니스트인공지능대학원

#인공지능기술면접

#인공지능기술인터뷰예시

#인공지능대학원

#인공지능대학원면접

#영어면접

#면접

#대학원면접

#AIGS인터뷰예시

#AI기술면접예시

#AI대학원기술면접

#AI대학원면접

#AI대학원면접질문

#AI대학원석박통합

#AI대학원영어면접질문

#AI대학원영어인터뷰

#UNIST

#기술면접예시

#인터뷰

원문링크 : UNIST Interview 2(면접)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티